|

| Robots.txt |

Pada kesempatan kali ini saya akan membahas tentang "Cara Mengatasi URL dicekal Robots.txt". Sebelum kita beranjak pada tutorial saya pada kali ini, alangkah baiknya kita memahami terlebih dahulu apa itu Robots.txt dan apa fungsinya ?

APA ITU ROBOTS.TXT ?

Robots.txt adalah sebuah file berformat text (.txt) yang wajib dimiliki oleh setiap situs di Internet yang didaftarkan pada mesin pencari seperti Google,Bing dan Yahoo. Jadi Robots.txt sangat erat hubungannya dengan SEO. Robots.txt berfungsi untuk mengontrol atau mengatur halaman direktori mana yang boleh dan tidak boleh ditelusuri/diindex mesin pencari.

CARA KERJA ROBOTS.TXT

Ketika situs anda berdomain namadomain.com didaftarkan pada mesin pencari ( Misal : Google), maka secara otomatis anda memperbolehkan atau mengijinkan robot perayap mesin pencari tersebut untuk mengunjungi dan merayapi situs namadomain.com. Kemudian pada saat robot perayap (bot crawler) mesin pencari itu mengunjungi situs anda, maka file yang pertama kali mereka rayapi ialah robots.txt tersebut. Jadi file robots.txt harus diletakkan pada direktori utama atau di folder_public.html. File robots.txt berisikan perintah-perintah halaman mana saja yang boleh dan tidak boleh diindex oleh mesin pencari. Hal ini tentu saja untuk melindungi halaman sistem anda untuk diketahui oleh orang-orang. Misalnya halaman administrator website yang merupakan halaman yang pantang untuk diketahui banyak orang atau diindex oleh mesin pencari. Sama halnya dengan website, blog juga memiliki robots.txt yang telah ditetapkan khusus dari Blogger. Untuk blog Blogspot, file robots.txt standarnya ialah

User-agent: Mediapartners-Google

disallow:

User-agent: *

disallow: /search

allow: /

sitemap:http://blogURL/feeds/posts/default?

Adapun arti dari kode-kode diatas ialah :

- "User-agent: Mediapartners-Google" : itu berarti bahwa kode yang ditempatkan dibawahnya hanya berlaku untuk Bot Crawler/robot perayap Mediapartners-Google. Mediapartners-Google adalah bot crawler untuk google adsense.

- "Disallow:" ini berarti bahwa tidak ada batasan halaman yang boleh ditelusuri oleh mesin perayap. Dengan kata lain, memungkinkan Crawler merayapi semua halaman di sebuah situs.

- "User-agent: *" ini berarti bahwa kode/perintah yang ditempatkan dibawahnya berlaku pada semua robot crawler (diwakili oleh kode '*')

- "disallow: /Search" melarang crawler/mesin perayap untuk mengunjungi URL yang memiliki awalan namablog.com/search

- "allow: / ini artinya memperbolehkan crawler/mesin perayap untuk mengunjungi semua halaman kecuali yang dicantumkan pada perintah disallow.

- "Sitemap:" Ini adalah sitemap dari situs anda yang diberitahukan kepada crawler/mesin perayap agar mudah ketika menjelajahinya lagi. Sitemap berisi semua link yang ada dsitus untuk ditelusuri oleh crawler/mesin perayap.

Setelah kita paham tentang kode-kode yang ada pada file robots.txt, maka langkah selanjutnya ialah mengupdate file robots.txt yang sudah ada dengan 2 cara yang akan saya sampaikan dibawah ini :

(Baca Juga : Cara Menddaftarkan Blog ke Webmaster Tools )

(Baca Juga : Cara Menddaftarkan Blog ke Webmaster Tools )

CARA MENGATASI URL YANG DICEKAL ROBOTS.TXT

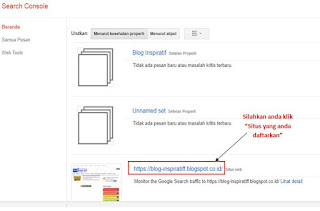

Cara Pertama1. Silahkan anda buka halaman Webmaster Tool anda, atau klik Link Webmaster/Tools/Home

2. Kemudian silahkan kalian klik pada situs yang pernah anda daftarkan ke Webmaster Tools, Contohnya seperti gambar berikut

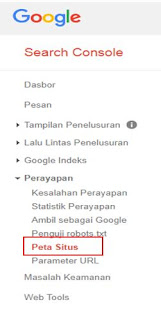

3. Pada tampilan selanjutnya, silahkan anda klik tab Perayapan ==> Peta situs

5. Selanjutnya, silahkan anda ketikkan ( feeds/posts/default?orderby=UPDATED ) tanpa tanda kurung buka tutup yah. lalu klik kirim.

CARA KEDUA

Cara kedua ini kita harus menambahkan settingan robots.txt khusus dan Tag tajuk robots khusus pada halaman blog anda. adapun caranya ialah sebagai berikut :

1. Silahkan anda masuk pada halaman Blogger

2. Pada tampilan dashbor blog anda, pilih Setelan ==> klik Preferensi penelusuran

3. Pada tampilan Preferensi penelusuran, silahkan anda scroll kebawah, hingga anda menemukan teks robots.txt khusus. Silahkan anda klik menu edit yang berada disebelah robots.txt khusus tersebut, dan pilih Ya. lalu anda masukkan kode berikut ini kedalamnya

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow:

Allow: /

Sitemap: https://blog-inspiratiff.blogspot.com/feeds/posts/default?orderby=updated

4. Silahkan anda ganti teks yang sudah saya Blok warna kuning diatas dengan URL Blog anda. lalu klik tombol Simpan perubahan.

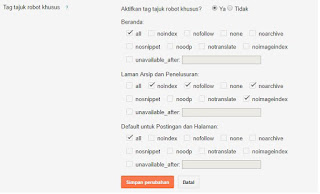

5. Tahapan selanjutnya ialah dengan menyetting Tag tajuk robots khusus. Caranya hampir sama dengan cara diatas, lakukan settingan Tag tajuk robots khusus dengan cara klik menu edit yang berada di samping Tag tajuk robots khusus dan lakukan settingan seperti gambar diabwah ini.

Settingan diatas bertujuan untuk memperbolehkan mesin pencari merayapi halaman beranda (Default) untuk Pos dan Laman, namun tidak memperbolehkan mesin pencari mengindex laman arsip dan penelusuran ( model pencarian yang terjadi di dalam blog ).

Sekian tutorial saya kali ini mengenai " ", proses pembaharuan data pada file robots.txt ini memang memerlukan waktu beberapa hari, jadi silahkan anda lihat URL yang dicekal robots.txt pada halaman Webmaster Tools anda secara rutin, untuk memastikan perubahan jumlah URL yang dicekal oleh robots.txt tersebut.

Silahkan berkomentar apabila ada yang ingin anda tanyakan seputar tutorial saya pada kali ini, atau mungkin anda mempunyai pertanyaan lain seputar artikel-artikel yang ada pada blog saya.

terima kasih telah berkunjung

Salam

No comments:

Post a Comment

1. Silahkan komentar secara baik dan bijak

2. Dilarang membuat Spam pada blog ini

3. Harap Ceklis "Notify Me/Beritahu Saya" sebelum Komentar di Publish agar komentar bisa segera dibalas

4. Mohon maaf jika ada komentar yang belum sempat dijawab/dibalas

Thanks for Visitting